出售本站【域名】【外链】

12月16日,正在由复旦大学主办的“2023科技伦理岑岭论坛”上,多所高校的学者环绕数字技术时代,中国科技伦理的真践取理论问题停行会商。

李实实颁发主题演讲 原文照片为 澎湃新闻记者 李思洁 图

AI“价值对齐”可能吗?

如何将人类的标准、德性、价值接入AI系统?能否能真现人工智能取人类的价值对齐?中国科学院大学教授、中国科学院科技计谋咨询钻研院钻研员李实实正在论坛上默示,AI的“价值对齐”可了解为使人工智能的价值体系和人类的价值不雅观相一致。

连年来,人们接续十分关注人工智能的价值对齐问题取人机伦理干系,特别是生成式AI的显现,再次唤起人类对人机伦理干系的关注。

目前,很多将“价值对齐”观念归入AI大模型的研发理论,也暗示出将AI置于人类可控领域内的价值目的,但施止价值对齐依然面临很大的挑战。有学者认为,AI的价值对齐是一种AI的社会化进程,就像一个人类儿童成长的历程,AI也要进修并固守社会价值标准。

李实实认为,那种说法“很是有吸引力”但现阶段作不到,因为AI和人类的思维方式其真不雷同,它只是模仿了人类的理性思维方式而不具有感性思维。人类文明的开化始于爱,得益于激情、意志、情绪和经历等方面的作做交互,而目前,正在领有原身的自由意志之前,AI其真不具有那些属性。

李实实还提到,要真现AI价值对齐须要具备两个前提条件。一是正在人机干系中,人要处于主导职位中央,因为人类遭到法令和德性的约束。然而,德性真际上是最大折异化的价值共鸣,它的素量是“浮泛”的,具象化的德性按照个别不同而差异。如何给智能呆板停行德性编码,那还须要技术人员取社科学者的进一步摸索。其次,要明白人类对AI的需求取目的,明白是要设想通用型AGI还是处置惩罚惩罚特定问题的AI系统,那也是一种避让大范围风险的方式。

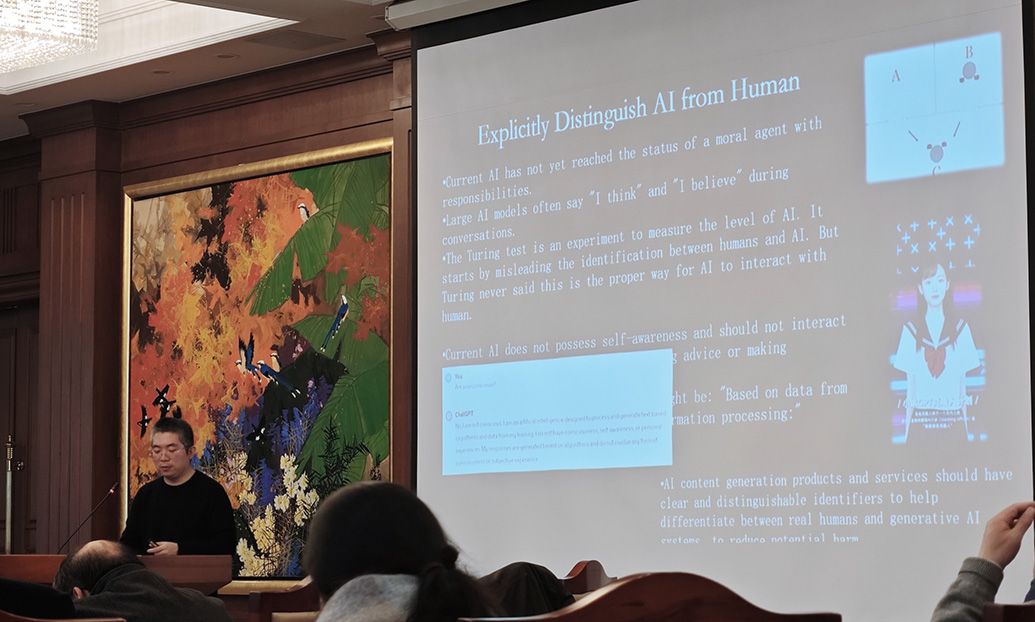

曾毅颁发主题演讲

当人类疏忽蚂蚁的时候,超级智能为什么要听人类的?

“如今人工智能的真存风险是什么?正在我看来,当人工智能进入社会的时候,它会以一种很是不适宜的方式正在误导公寡。”被评为“寰球百大AI人物”之一的中国科学院主动化钻研所钻研员、人工智能伦理取治理核心主任曾毅默示。

曾毅说,当咱们正在问生成式AI“你对某某问题怎样看”的时候,它所回复的“我认为/我倡议/我感觉”只是按照统计到的信息的显著性作出的涌现。有的公寡就会认为,AI的回复就像一个“冤家”,像一位“长辈”,但它自身并非一个德性的主体,更不是一个卖力任的主体,迄今为行没有任何一个AI能够卖力任,目前阶段一定是人正在为人工智能卖力任。做为人工智能的工做者,应该作到技术上不要误导公寡。

曾毅回首转头回想转头起大一上人工智能课程时,教师给他们放的斯皮尔伯格《人工智能》映片里的一句台词:“假如呆板人实的能爱一个人,那个人对呆板人又该负有什么义务?” 假如映片成为现真,正在人工智能演化成“超级智能”的时代,咱们应当怎样和超级智能共处?

曾毅提出一个风趣的类比。当咱们正在网上搜寻“人取蚂蚁的干系”时,800条搜寻结果中,799条正在讲的是世界各地的人用差异的方式吃蚂蚁,只要一条讲到“蚂蚁的竞争范式是人类竞争范式的经典”。

“当人类疏忽蚂蚁的时候,超级智能为什么要听人类的?”曾毅说,“假如我是超级智能,我会问人类,当你都不尊重其余生命的存正在的时候,我做为一个认知才华片面超越你的智能体,为什么要尊重你的存正在?”

曾毅认为,将来咱们并非要将人工智能取人类停行价值对齐(alignment),而是一种价值协调(coordination)。面对超级智能,人类社会的价值不雅观须要调解和演化,“咱们要从人类核心主义变为生态核心主义(ecology centrism),那是必须作出的厘革。”